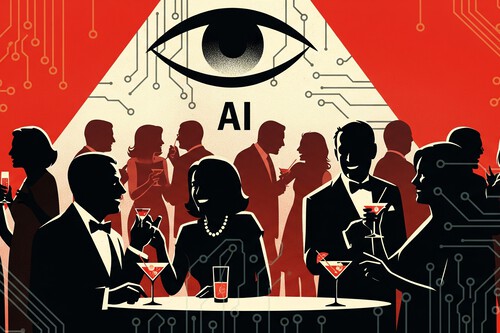

Em uma mansão com vista para a Golden Gate, a elite da inteligência artificial se reuniu no último domingo para debater uma questão inquietante: o fim da humanidade e o que virá depois. Entre taças (sem álcool), os cerca de 100 participantes — entre eles filósofos, empresários e pesquisadores — imaginaram um futuro no qual os humanos não existem mais, mas existe uma inteligência criada por nós. Como deveria ser nossa sucessora?

A festa do fim do mundo

O evento, que se tornou público por meio desta reportagem da Wired, foi chamado de “Worthy Successor” (Sucessor Digno) e tinha como objetivo discutir exatamente isso: definir um “sucessor à altura” para quando a humanidade deixar de existir. Essa ideia está relacionada à criação de uma inteligência artificial geral, ou AGI (sigla em inglês). Um conceito — por enquanto — de superinteligência que superaria o ser humano em todas as facetas do conhecimento, tão avançada que, nas palavras de Daniel Faggella, anfitrião da festa: “Você preferiria, com toda certeza, que ela (e não a humanidade) determine o caminho futuro da própria vida”.

Primeiramente: quem é esse cara e por que deveríamos ouvi-lo? Faggella é fundador da Emerj Artificial Intelligence Research, uma empresa de consultoria e análise de IA. Em 2016, ele escreveu no TechCrunch sobre os riscos da IA e atualmente está focado em divulgar informações sobre IA a partir de um enfoque moral e filosófico, especialmente a ideia da criação desse “worthy successor” — uma ideia que ele já vinha amadurecendo há algum tempo. Segundo ele mesmo conta no LinkedIn, foi contatando diversas personalidades relevantes da indústria para, dois anos depois, conseguir realizar essa reunião.

Na festa, três palestras foram apresentadas, sendo uma por Ginevra Davis, escritora nova-iorquina, outra pelo filósofo Michael Edward Johnson e uma pelo próprio anfitrião. A lista completa de convidados não foi divulgada, mas Faggella se gaba de que participaram fundadores de empresas de IA avaliadas em até 5 bilhões de dólares, pessoas dos laboratórios que pesquisam para criar uma AGI e alguns dos filósofos e pensadores mais importantes do setor.

A superinteligência que acabará com tudo

Nas palavras de Faggella à Wired: “os grandes laboratórios sabem que a AGI provavelmente acabará com a humanidade, mas não falam sobre isso porque os incentivos não permitem”. Parece teoria da conspiração, mas ele não é o primeiro a alertar sobre algo assim. Há uma década, Bill Gates já dizia que deveríamos temer a IA. Pouco depois, Elon Musk exigiu uma regulamentação para mitigar os perigos do que estava por vir. Mais recentemente, vários especialistas em IA assinaram uma carta alertando para o “risco de extinção pela IA”. A OpenAI também analisa os riscos da AGI. Diz-se até que as declarações sobre a criação da AGI foram motivo para o polêmico desligamento de Sam Altman meses depois.

Não podemos saber com certeza o que há de verdade nisso tudo, mas sabemos que a maioria dos argumentos sobre a iminência da AGI e seus riscos baseiam-se em opiniões e especulações, não em evidências empíricas ou avanços concretos. Por exemplo, pesquisas recentes mostram que os sistemas atuais ainda falham em tarefas básicas de raciocínio, o que contradiz a ideia de uma superinteligência em curto prazo. Além disso, há indícios de que a IA generativa pode estar perto de seu limite máximo. Também não há consenso entre os especialistas. Existem críticos que consideram essas ideias ridículas, mas, claro, isso é menos “viralizável” do que dizer que a IA vai nos extinguir.

E o mais importante: não podemos deixar de lado o fato de que quem faz essas declarações são pessoas envolvidas no negócio, como Altman, e esse negócio é muito caro e precisa de financiamento. Agitar a inquietação sobre a iminente chegada da AGI pode ser uma forma de arrecadar mais dinheiro para suas empresas.

O que deixaremos quando desaparecermos

O tema central da festa não foi tanto como a humanidade se extinguirá (isso parece dado como certo), mas que tipo de inteligência deveríamos criar para ser nossa sucessora. Os participantes ouviram palestras que giraram em torno dos valores e capacidades que essa nova inteligência superior deveria ter. Para Faggella, a humanidade tem a responsabilidade de projetar um sucessor consciente e capaz de evoluir.

O filósofo Michael Edward Johnson destacou os riscos de criar uma IA consciente além da já batida possível extinção: “Arriscamos escravizar algo que pode sofrer ou confiar em algo em que não se pode confiar”, afirmou durante sua palestra. Mais do que forçar a IA a obedecer, ele propôs uma educação conjunta de humanos e IAs para “perseguir o bem”, seja lá o que isso for. Em suma, um debate interessante do ponto de vista ético e filosófico, mas com pouco vínculo com a realidade. Pelo menos, por enquanto.

Imagem de capa | Gemini

Este texto foi traduzido/adaptado do site Xataka Espanha.