Nos últimos anos, nos acostumamos com uma ideia bastante difundida no mundo da IA: modelos mais rápidos geralmente são menos inteligentes do que aqueles que levam mais tempo para responder. Essas variantes "leves" funcionam muito bem em termos de custo e latência para muitas aplicações, mas quando o raciocínio é decisivo, o usual tem sido aprimorar o modelo.

No entanto, na corrida para liderar o desenvolvimento da inteligência artificial, algo incomum acaba de acontecer. O Gemini 3 Flash, novo modelo do Google, superou o GPT-5.2 Extra High, a variante mais capaz de raciocínio da OpenAI, em diversos testes de desempenho. Isso nos força a repensar algumas regras que considerávamos certas.

Modelo rápido que também raciocina

O novo modelo do Google vem com uma promessa muito específica: demonstrar que "velocidade e escalabilidade não precisam vir à custa da inteligência". Embora tenha sido projetado com foco na eficiência, tanto em termos de custo quanto de velocidade, o Google insiste que o Gemini 3 Flash também se destaca em tarefas de raciocínio.

Segundo a empresa, o modelo pode aprimorar sua capacidade de raciocínio. Ele consegue "pensar" por mais tempo quando o caso de uso exige, mas também utiliza, em média, 30% menos tokens do que o Gemini 2.5 Pro, considerando tráfego típico, para concluir uma ampla variedade de tarefas com alta precisão e sem comprometer o tempo de resposta.

A verdade está nos benchmarks

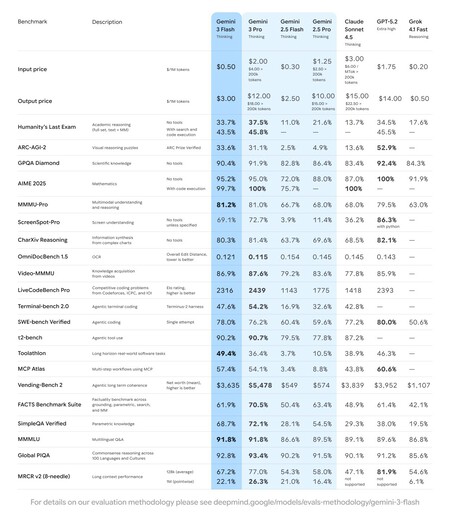

Benchmarks ainda são uma das ferramentas mais úteis que temos para comparar modelos de IA, colocá-los frente a frente e detectar em quais cenários eles têm melhor ou pior desempenho. Nesse quesito, o Gemini 3 Flash se destaca.

No SimpleQA Verified, teste que mede a confiabilidade em perguntas de conhecimento, o Gemini 3 Flash alcança 68,7%, comparado a 38,0% do GPT-5.2 Extra High. No raciocínio multimodal, dentro do MMMU-Pro, o modelo do Google pontua 81,2%, comparado a 79,5% do OpenAI. No Video-MMMU, o Flash atinge 86,9%, comparado a 85,9% do GPT-5.2 Extra High.

Em termos de capacidades multilíngues e culturais, o Flash também se destaca, com 91,8% em comparação com os 89,6% do GPT-5.2 Extra High. No Global PIQA, focado no senso comum em 100 idiomas, a diferença permanece: 92,8% para o Flash em comparação com 91,2% para o modelo da OpenAI. O Gemini 3 Flash agora está especialmente otimizado para captar nuances fora do inglês e raciocinar com mais fluência em contextos globais.

Ele também se destaca no uso de ferramentas e agentes. No Toolathlon, o Flash alcança 49,4% contra 46,3% do GPT-5.2 Extra High. No conjunto de benchmarks FACTS, a diferença é menor, mas ainda favorece o Google: 61,9% contra 61,4%. Em tarefas de execução de ferramentas de longo prazo, o Flash parece apresentar maior consistência.

Não é o rei do raciocínio puro

Agora, vale a pena analisar o panorama geral. Embora o Gemini 3 Flash supere o melhor modelo da OpenAI em diversos testes, se considerarmos o raciocínio "puro", o equilíbrio se altera. Nos testes mais exigentes nessa área, o GPT-5.2 Extra High continua sendo a referência.

O modelo da OpenAI lidera o ARC-AGI-2, focado em quebra-cabeças visuais, com 52,9% em comparação com 33,6% do Flash. No AIME 2025, com execução de código, atinge 100% em comparação com 99,7%. E no SWE-bench Verified, voltado para engenharia de software, ele obtém 80,0% em comparação com 78,0% do Gemini 3 Flash.

O que exatamente é o GPT-5.2 Extra High?

Ao longo do artigo, o nome GPT-5.2 Extra High aparece diversas vezes, e é normal se perguntar se é algo novo ou pouco conhecido. Na realidade, não é um modelo que costuma ser mencionado ao público em geral.

O Google usa esse nome em sua tabela comparativa para se referir ao nível máximo de raciocínio disponível na API OpenAI para GPT-5.2 Thinking e Pro. Na documentação oficial da OpenAI, ele é identificado como "xhigh".

Onde o Gemini 3 Flash pode ser usado?

O acesso ao Gemini 3 Flash não depende de país. Se você tem acesso ao aplicativo Gemini, já está usando esse modelo, que se tornou o padrão. Ele também está disponível para desenvolvedores por meio da API, do AI Studio e do Vertex AI. Nos Estados Unidos, a implementação vai um passo além, com o Gemini 3 Flash se tornando o modelo padrão do Modo IA do mecanismo de busca do Google.

Acabaram-se os dias em que o Google tentava competir com o ChatGPT com o Bard, ou em que a OpenAI parecia estar anos à frente das demais. Hoje, as distâncias entre os grandes players de IA diminuíram drasticamente. A competição é mais direta, mais técnica e, acima de tudo, muito mais acirrada.

Imagens | Google

Ver 0 Comentários