O GPT-5 é um pouco melhor que o GPT-4. O problema dessa frase está na palavra “um pouco”. O novo modelo “unificado” da OpenAI não parece representar o salto qualitativo que muitos esperavam, e isso voltou a acionar os alertas. Pode-se perguntar: e se a IA não conseguir ir muito além do que é agora? Mas talvez isso já esteja acontecendo. A pergunta então é outra: o que fazer a seguir?

Em 2020, uma equipe de pesquisadores da OpenAI publicou um estudo intitulado “Leis do escalonamento para Modelos Neurais de Linguagem”. Nele, propunham uma espécie de Lei de Moore da IA: quanto mais dados e poder de computação você dedicasse para treinar os modelos, melhores eles seriam. Essa observação se mostrou clara quando lançaram o GPT-3, que era 10 vezes maior que o GPT-2, mas muito, muito melhor que aquele modelo.

Gary Marcus, professor de psicologia e ciências neurais na Universidade de Nova York, explicou em 2022 que aquele estudo não fazia muito sentido: “as chamadas leis do escalonamento não são leis universais como a da gravidade, mas apenas meras observações que podem não se manter para sempre”. Até Satya Nadella concordou com essa afirmação alguns meses atrás no evento Ignite 2024. E, como estamos vendo, suas dúvidas se confirmaram. O escalonamento funciona, e os modelos são um pouco melhores que seus predecessores, mas a desaceleração parece estar presente.

Mas o GPT-5 não é tão ruim

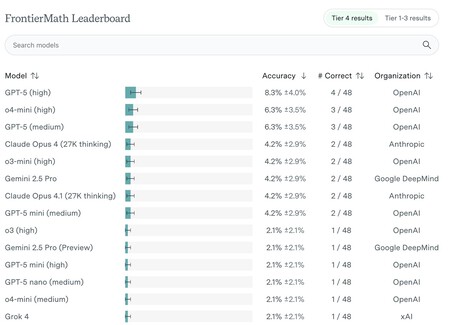

Na verdade, o GPT-5 melhorou em métricas relevantes. Os responsáveis da Epoch AI avaliaram seu desempenho no FrontierMath, por exemplo. Os resultados foram um pouco melhores que os de seu predecessor o4-mini, mas não houve grandes saltos de rendimento. Ainda assim, destacaram que o GPT-5 foi o primeiro modelo a conseguir resolver um problema concreto como se “tivesse compreendido totalmente o problema”.

No âmbito da matemática, o GPT-5 se sai um pouco melhor que seus predecessores, mas a diferença não é radical. Os problemas mais difíceis (Tier 4) continuam sendo quase impossíveis para os modelos de IA. Fonte: Epoch AI.

No âmbito da matemática, o GPT-5 se sai um pouco melhor que seus predecessores, mas a diferença não é radical. Os problemas mais difíceis (Tier 4) continuam sendo quase impossíveis para os modelos de IA. Fonte: Epoch AI.

Outra análise independente do analista Zvi Mowshowitz indica que, embora o modelo base do GPT-5 seja apenas correto, suas variantes avançadas (GPT-5 Pro e GPT-5 Thinking) representam uma melhoria substancial em relação ao o3-Pro e o3, respectivamente, sobretudo ao reduzir as alucinações. Segundo seus dados, o “GPT-5 Auto” (a versão base) parece um produto pobre, a menos que você use o plano gratuito do ChatGPT.

A IA simbólica (“clássica”) representa o conhecimento usando símbolos e regras e se baseia na lógica e no raciocínio formal para resolver problemas e tomar decisões. Esse tipo de IA dominou o cenário até os anos 90, mas a falta de avanços notáveis fez com que a disciplina estagnasse, entrando em um inverno da IA. “Saímos” dele com a IA conexionista, redes neurais que representam o conhecimento por meio de conexões e pesos dos nós de uma rede de neurônios artificiais. Essa disciplina deu origem ao auge da IA generativa e ao sucesso estrondoso do ChatGPT e seus concorrentes. Seu desempenho surpreendentemente bom desencadeou a atual febre da IA, mas os avanços de rendimento estão desacelerando.

Os céticos da IA intensificam seu discurso

Analistas como Ed Zitron — mais extremo — ou Gary Marcus — defensor da IA simbólica — sempre alertaram sobre as expectativas exageradas geradas pela IA generativa. Até mesmo aqueles que foram fundamentais na criação do ChatGPT, como o engenheiro Ilya Sutskever, advertiam sobre as limitações do escalonamento. Os modelos de raciocínio suavizaram as críticas e são uma grande alternativa para esse aparente estagnação dos modelos padrão, mas, mesmo com eles, a sensação é de que a IA não vai avançar muito além.

Assim, nunca chegaremos a uma AGI (inteligência artificial geral). Thomas Wolf, cofundador e Chief Science Officer da Hugging Face, refletiu sobre o problema alguns meses atrás e chegou à conclusão de que as IAs se tornaram “um país de homens que dizem sim a tudo em servidores”. Para ele, as coisas começavam a ficar inquietantes:

“Para criar um Einstein em um data center, não precisamos de um sistema que tenha todas as respostas, mas sim de um que seja capaz de se questionar sobre coisas que ninguém havia pensado ou ousado perguntar.”

Como apontava esse especialista, a IA atual normalmente não gera novo conhecimento e “simplesmente preenche lacunas do que os humanos já sabiam”. A IA atual é como um estudante fantástico e muito aplicado, mas esse estudante não desafia o que foi ensinado. Não questiona nem propõe ideias que vão contra os dados com os quais foi treinado. Yann LeCun, um dos pioneiros da IA, já chegou a uma conclusão sobre a IA generativa atual: ela é muito limitada.

Reduzindo expectativas

O panorama é preocupante para quem está investindo bilhões de dólares em data centers ou no treinamento de novos modelos fundamentais, sobretudo porque esse impacto pode não ser tão gigantesco quanto haviam previsto e prometido. Ed Zitron indica na The New Yorker que “este é um mercado de 50 bilhões de dólares, não de um trilhão de dólares”. Marcus concordava: “De 50 bilhões, sim. Talvez de 100 bilhões”.

Se a IA de fato estagnou, o que podemos esperar é que se torne uma ferramenta útil para economizar tempo e melhorar os resultados de certas tarefas — como já está fazendo —, mas não para provocar aquele impacto sísmico na sociedade e no emprego que personalidades como Altman, Musk, Amodei ou Zuckerberg defendem com seus investimentos. Se isso acontecer, teremos sem dúvida uma ferramenta poderosa para fazer as coisas melhor e mais rápido, que é exatamente o que outras grandes disrupções, como o PC ou a internet, nos proporcionaram.

Mas muitos provavelmente esperavam mais. Muito mais. E aí está o problema: nas expectativas.

Imagem | Levart Photographer

Este texto foi traduzido/adaptado do site Xataka Espanha.

Ver 0 Comentários