O texto a seguir é uma tradução do relato de Guille Lomener, editor do Applesfera

Certamente você já se deparou com manchetes como: "Adeus à edição manual", "O Photoshop se integra ao ChatGPT e muda tudo", "A aliança definitiva entre OpenAI e Adobe". Com essa combinação, é fácil imaginar uma espécie de super IA que faz tudo sozinha: você pede uma foto do pôr do sol e ela a monta para você em segundos.

A realidade é outra. Depois de usar essa integração do Photoshop no ChatGPT, minha conclusão é diferente: não se trata de um substituto para o Photoshop, nem de um gerador de imagens do tipo Google Gemini ou Image Playground Nanobana. É mais como um Photoshop básico que funciona dentro do chat e age como um professor: faz algumas coisas para você, permite que você mexa nas configurações e, principalmente, explica o "porquê" de cada alteração.

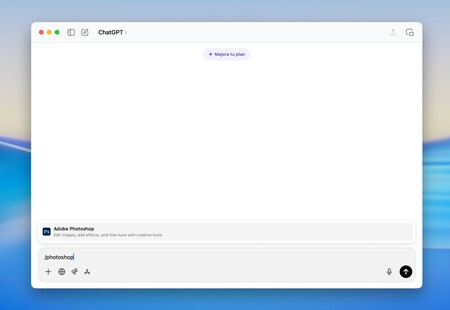

Como usar o Photoshop no ChatGPT

Para usá-lo, a maneira mais prática é usar o aplicativo ChatGPT no Mac ou iPhone (no Android, por enquanto, não está disponível). Na caixa de texto onde você normalmente digita, basta usar o comando /photoshop e selecionar a extensão quando ela aparecer. Não é necessário fazer login com a Adobe nem instalar nada extra.

A partir daí, você pode fazer duas coisas:

- Carregar uma foto e dizer diretamente o que deseja: "Quero editar esta imagem", "desfocar o fundo", "remover o fundo e me deixar um PNG".

- Ou perguntar primeiro: "O que você pode fazer?" para obter uma lista de todas as funções disponíveis.

E aqui está o primeiro ponto importante: o que você tem diante de si não é um novo gerador de imagens, mas sim uma espécie de versão reduzida do Photoshop, focada principalmente na edição de cores e retoques básicos.

O que a própria extensão diz que sabe fazer

Quando você pergunta à extensão do Photoshop o que exatamente ela pode fazer, a resposta é:

🖼️ Seleções e Skins

- Selecionar a pessoa de uma foto automaticamente

- Selecionar objetos específicos com um comando (por exemplo: "selecionar o céu", "selecionar o chapéu", "selecionar todas as árvores")

- Criar máscaras para editar apenas parte da imagem

🎨 Ajustes de imagem (com controles interativos)

- Brilho

- Contraste

- Saturação

- Exibição

- Balanço de Branco

- Preto e branco

- Tons, sombras e luzes

✨ Efeitos e filtros

- Glitch

- Duotone

- Tritone

- Bloom

- Bokeh

- Desfoque de movimento

- Granulação

- Pixelate

- Comic / Cartoon

- Meio-tom, etc

📌 Edições mais avançadas

- Desfocar o fundo (com seleção automática de pessoa)

- Remover o fundo e exportar PNG transparente

- Desfazer etapas específicas ou reverter para a imagem original

A parte boa: tudo funciona praticamente como um Photoshop recortado, sem sinal de IA generativa, como "trocar meu fundo por um pôr do sol na praia" no estilo de Firefly ou Gemini.

Prova real: uma foto no parque

Para testar, sempre usei a mesma imagem: eu com AirPods, num parque, com um céu azul ao fundo. Sobre essa foto, fiz várias solicitações, como um usuário normal faria.

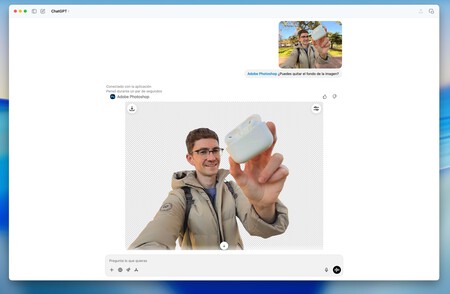

Remover o fundo

Primeiro teste: "Remover o fundo e deixar a silhueta em PNG." Aqui o selo da Adobe é perceptível. O recorte funciona bem, a pessoa fica nítida e a exportação em PNG é muito útil para apresentações, miniaturas ou montagens rápidas. Nesse quesito, é uma das melhores integrações.

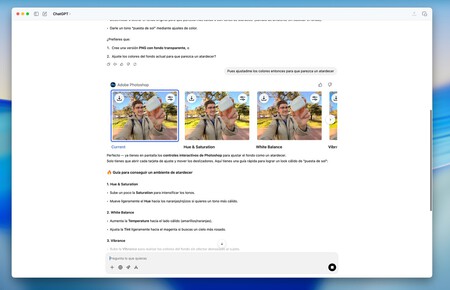

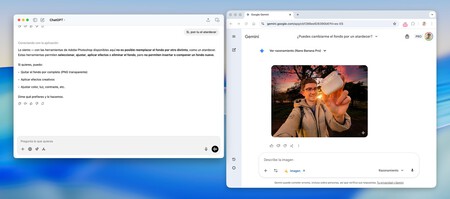

Mude o fundo para um pôr do sol

Segundo teste: "Agora coloque um pôr do sol no fundo." Aqui toda a fantasia de marketing desmorona: a extensão não é capaz de gerar esse novo fundo do zero. Ela não usa o Firefly nem se baseia no mecanismo generativo do ChatGPT para inventar a paisagem, ao invés disso, faz é algo muito diferente: propõe que você mexa nos parâmetros de cor.

Ela sugere que você brinque com a saturação, o balanço de branco, os tons quentes... Ou seja, ensina como você poderia "simular" um ambiente de pôr do sol modificando as cores da foto original. O resultado pode ser convincente, mas ainda é edição clássica, não criação de conteúdo novo.

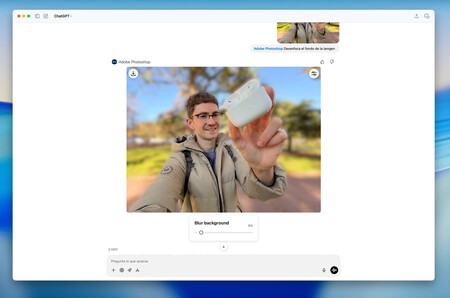

Desfocar o fundo

Terceiro teste: "Desfocar o fundo e manter o foco." Funciona. Detecta bem a figura humana, aplica um desfoque ao fundo e, com alguns ajustes manuais, é possível obter um efeito de Modo Retrato bastante decente.

Um visual "azulado e laranja"

Quarto teste: "Quero um efeito cinematográfico azulado e laranja." Aqui, a filosofia desta integração é bem compreendida.

Ele não aplica uma predefinição que o deixe sem ideias logo de cara. Ele te guia: te diz quais tons usar, como aproximar cores frias do ciano, aquecer as luzes, etc. O resultado final veio do meu próprio ajuste dos controles, seguindo as recomendações, e não de uma única instrução do tipo "faça por mim". Novamente, ele age mais como um professor do que como um editor freelancer.

Mais parecido com o app Fotos da Apple do que com o Google Gemini

Com tudo isso em mente, ele se parece muito com o app Fotos do iPhone, só que com um diferencial: você pode fazer perguntas, pedir conselhos e deixar que ele abra os controles que você precisa a qualquer momento. Não é exatamente isso que esperamos da futura Siri?

Imagine poder dizer ao seu iPhone: "Siri, deixe esta foto mais quente e desfoque o fundo" e ter o sistema ajustando os controles do app Fotos para você. Considerando que a Apple já colabora com o Google Gemini e que o iOS 26.4 está prestes a ser lançado, a implementação seria tecnicamente muito fácil.

As ferramentas já existem (brilho, contraste, modo retrato), o que falta é a inteligência que entenda o que queremos e execute as ações automaticamente, assim como o Photoshop faz no ChatGPT.

Por outro lado, essa fusão entre Adobe e OpenAI está muito aquém do Google Gemini em tudo o que se refere à geração de conteúdo. O Gemini é capaz de trocar planos de fundo por outros totalmente novos, inventar elementos e transformar uma cena real. O Photoshop no ChatGPT, atualmente, não chega a esse nível.

Embora o Photoshop possua IA generativa, sua essência ainda é a edição manual e um tanto tradicional de fotos. Mas se o esperado era escrever uma frase e ter a IA reconstruindo a imagem com um novo plano de fundo, objetos adicionados e um estilo bem específico, essa integração deixa a desejar.

Então, para que serve o Photoshop no ChatGPT?

Com base no que observei, eu resumiria da seguinte forma:

- Para aprender e experimentar o Photoshop sem medo. Se você sempre se sentiu intimidado pelo Photoshop, aqui está uma porta de entrada amigável. Você pergunta o que fazer, ele explica o porquê e você vê o resultado em tempo real.

- Para recortar fundos e criar PNGs rapidamente. O recorte da pessoas e a exportação com fundo transparente são os recursos mais úteis de toda a integração.

- Para retoques simples de cor. Alterar a temperatura da cor, dar um aspecto quente ou frio, adicionar granulação, experimentar um efeito de glitch... tudo isso funciona muito bem.

- Não para substituir seu fluxo de trabalho profissional. Se você já trabalha com o Photoshop, se sentirá muito mais confortável com o aplicativo completo, com suas camadas, suas máscaras avançadas e, quando estiver tocando na tela, o Firefly.

Não se trata de competir com o Google Gemini em edição generativa. Aqui, por enquanto, o Gemini ainda está em outro patamar quando o assunto é transformar radicalmente imagens apenas com texto.

Após várias tentativas, cheguei à seguinte conclusão: o Photoshop no ChatGPT é um bom colega de classe, não o aluno brilhante que faz tudo por você. Ele te ajuda, explica, abre os menus certos e permite que você mexa com certa confiança, mas a edição continua sendo sua.

Ver 0 Comentários