Em 2012, o furacão Sandy devastou o Mar do Caribe e atingiu a costa de Nova York. Lá, deixou para trás inundações, cortes de energia e fotos espetaculares. De todas elas, uma em particular se destacou e viralizou, mas havia um problema: era falsa; e não foi a única a vazar nas redes.

Essa imagem foi apenas mais um exemplo do que temos visto antes e depois: grandes fenômenos e eventos acabam gerando uma enxurrada de conteúdo, parte sendo falsa.

Há muitas razões pelas quais as pessoas se aproveitam desses momentos para espalhar imagens falsas, mas pelo menos antes, obter imagens e vídeos convincentes era caro. Somente usuários avançados de aplicativos como Photoshop ou Final Cut/Premiere conseguiam resultados convincentes, mas a IA, como sabemos, mudou tudo isso.

Distinguir entre o que é real e o que é gerado por IA está se tornando cada vez mais difícil e, recentemente, tivemos o último grande exemplo dessa tendência.

Anatomia de um deepfake

A península de Kamchatka, no extremo leste da Rússia, foi atingida por uma nevasca histórica. A pior em décadas, segundo registros, com níveis de neve superiores a dois metros em diversas áreas, de acordo com a agência Xinhua.

Petropavlovsk-Kamchatsky, o centro administrativo, industrial e científico do Krai de Kamchatka, sofreu especialmente com essas consequências, e os moradores da região divulgaram nas redes sociais imagens do que já foi apelidado de "apocalipse da neve". Essas imagens, disseminadas pela mídia e pelas redes sociais, que eram reais – muitas vezes mais "mundanas" e bem menos espetaculares – contrastam com outras que, teoricamente, também mostravam a situação de várias partes da região, mas que, na verdade, foram geradas por inteligência artificial.

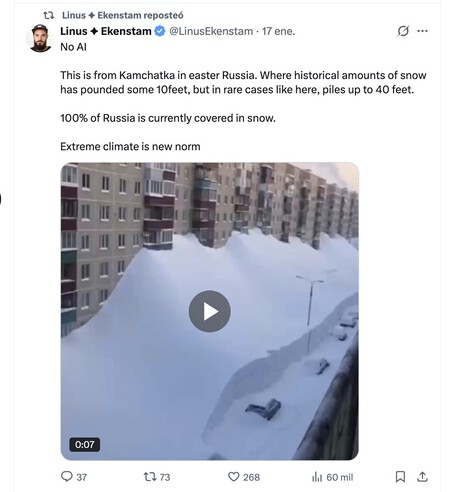

Um vídeo, por exemplo, foi compartilhado há alguns dias por Linus Ekenstam, influenciador que costuma compartilhar notícias e reflexões sobre IA. Ele republicou o conteúdo e afirmou que era real, mas logo vários usuários indicaram que o vídeo, na verdade, havia sido criado por IA.

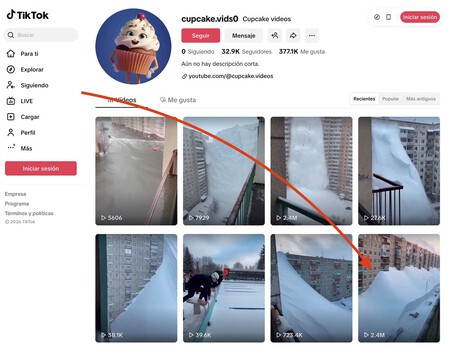

Ekenstam argumentou que o erro teórico apontado pelo usuário não era tão grave e que, onde ele mora, há postes perto dos postes de luz. Ele tentou, portanto, defender que, para ele, o vídeo era real, mas outros apontaram que não era. A prova definitiva: um usuário compartilhou o suposto vídeo original, que aparentemente se originou de uma conta do TikTok dedicada justamente a disseminar conteúdo gerado por IA que parece real.

O ponto crucial desse vídeo falso é que ele é espetacular, mas não exageradamente espetacular. É, até certo ponto, verossímil, e quando a imagem e o movimento da câmera são tão convincentes, é difícil pensar que "talvez seja gerado por IA".

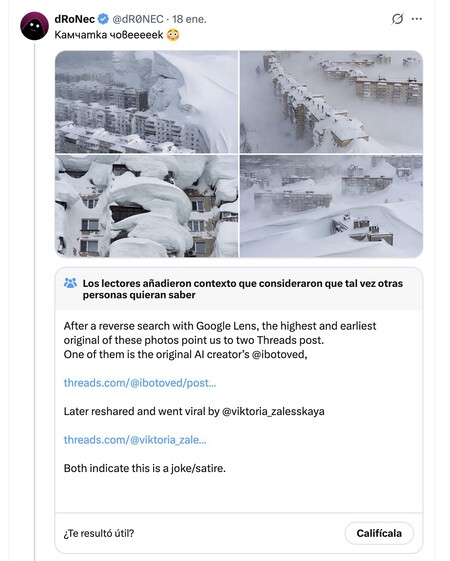

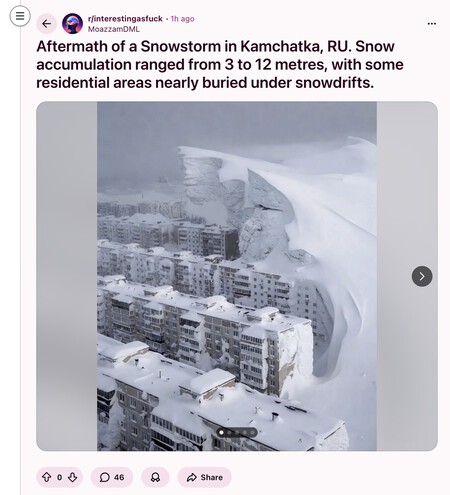

Com a nevasca que atingiu Kamchatka, imagens incomuns foram compartilhadas nas redes sociais, muito mais típicas de um filme distópico de Hollywood do que de um fenômeno natural real. A priori, as imagens podem até parecer coerentes, mas um exame mais detalhado – e sobretudo mais crítico – facilita a percepção de que talvez essas imagens não sejam tão reais quanto parecem.

De fato, as imagens mais impactantes compartilhadas nas redes sociais e que acumulam milhares de retweets e curtidas no TikTok, por exemplo, contrastam com as publicadas na mídia tradicional, que costumam ser bem menos impactantes e muito mais banais.

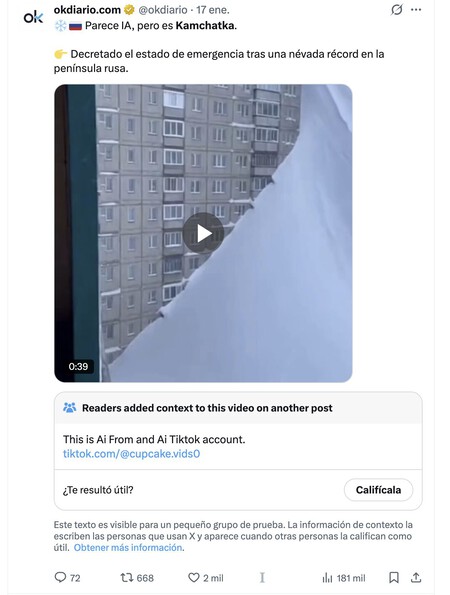

Veículos de comunicação chegaram a publicar algumas imagens e vídeos gerados por inteligência artificial em suas plataformas digitais ou redes sociais sem perceber que esses vídeos, na verdade, se originaram da conta do TikTok mencionada anteriormente, que conseguiu disseminá-los rapidamente.

Debates sobre a possibilidade de certas imagens serem reais têm sido frequentes, por exemplo, no Reddit, onde usuários compartilharam, por exemplo, uma captura incrível que, quando analisada em detalhes, parecia ter sido gerada por IA.

A avalanche de "jornalismo cidadão", que pode ser bem-intencionada e muito importante, contrasta com o papel da mídia, que tem uma enorme responsabilidade como fonte confiável de informação.

Até mesmo eles (e nós) podemos cair na armadilha, e aqui, mais uma vez, o melhor a fazer é começar a desconfiar do que vemos nas telas, pois pode ser conteúdo falso. Os vídeos que apareceram em alguns veículos, como Sky News ou La Vanguardia, são combinados com outros que (pelo menos a priori) parecem reais, mas que, neste momento, também exigem uma análise rigorosa.

Nosso cérebro nos trai e a tecnologia sabe disso

Existem diversos fenômenos psicológicos e vieses cognitivos bem estudados que explicam por que acreditávamos em notícias falsas no passado e agora o mesmo acontece conosco novamente com os deepfakes.

Não importa se sabemos (ou pelo menos suspeitamos) racionalmente que essas imagens e vídeos são falsos: a tecnologia, e especialmente a IA, exploram precisamente esses vieses. Entre eles, podemos citar:

- Viés de confirmação: Acreditamos no que se encaixa com o que já acreditamos. Nosso cérebro não busca tanto a verdade em si, mas sim a coerência interna. Assim, se uma notícia reforça nossa ideologia, diminuímos o nível de críticas potenciais, mas se a contradiz, a analisamos minuciosamente ou a descartamos diretamente. O problema é que a IA pode gerar conteúdo sob medida para cada narrativa.

- Efeito da verdade ilusória: ocorre o princípio de que "se eu vi muitas vezes, será verdade". A repetição aumenta a sensação de veracidade, não a veracidade real, e é algo que, por exemplo, as redes sociais, máquinas de replicação de boatos, exploram ao máximo. Novamente, a IA facilita a produção em massa da mesma mentira com mínimas variações.

- Acreditamos no que vemos: é o que alguns chamam de realismo perceptual. Confiamos demais no visual, daí o famoso ditado "uma imagem vale mais que mil palavras". As imagens são processadas muito mais rapidamente do que o texto, e o pensamento crítico vem depois da reação emocional, como argumentou Daniel Kanheman em seu famoso livro "Rápido e Devagar: Duas Formas de Pensar".

- Carga cognitiva: relacionado ao que foi dito acima, pensar criticamente é cansativo, o que significa que, quando estamos cansados, distraídos ou com pressa, usamos atalhos mentais. O famoso e preocupante hábito de "doomscrolling" se aproveita muito bem dessa armadilha, e tanto as notícias falsas quanto os deepfakes são projetados para serem fáceis de acreditar, não para serem analisados.

Há mais, é claro. A IA já gera resultados convincentes, mas também – especialmente em textos – sua segurança ao comunicar e expressar essas informações ativa um viés de autoridade. É como se parecesse mais confiável do que se fosse dito por um especialista humano que, por algum motivo, não tem a mesma facilidade em comunicar seu conhecimento com habilidade.

O conteúdo gerado por IA também se aproveita desses grandes fenômenos e eventos que maximizam o impacto emocional, e há também o fato de que, quando muitas pessoas o compartilham, é porque "deve ser verdade" e porque tendemos a acreditar que são os outros que caem nesses enganos, não nós.

Como dito, cuidado por aí.

Ver 0 Comentários